Préparer avec votre agence de référencement naturel un audit seo compréhensif et efficace pour fixer rapidement ses objectifs.

Pourquoi réaliser un audit de référencement

Avant de se lancer en marketing de recherche, il apparait indispensable de faire un état des lieux du projet web. L’audit SEO va à ce titre aider les décideurs à connaître la situation par une analyse interne et externe. En effet, il semble difficile de mettre en place un plan d’action sans connaître précisément :

- Les fonctionnalités du site qui facilitent ou détériorent le positionnement des articles.

- La structure du site pour vérifier si le budget crawl ne freine pas l’exploration des boots de Google.

- La composition sémantique du site pour adapter les liens internes et externes au site.

- Les opportunités de mots-clés pour vérifier si l’on peut facilement se positionner sur des occurrences stratégiques.

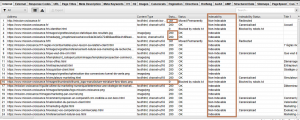

Étape 1 : lancer une analyse screaming frog

Dans cet article nous allons voir cela sur un exemple de site et démarrer à partir de screaming frog pour connaître l’état des urls. Avant d’entamer un contrôle en profondeur, il semble évident de surveiller l’exploration de votre site. Parfois, on s’aperçoit des difficultés dès ce premier niveau. En agissant, de belles surprises peuvent satisfaire nos objectifs.

Comprendre le statut :

200 : pas de problème particulier, bien qu’il faille examiner dans le détail si cela correspond à nos besoins.

301 : redirection permanente, la page provient d’une redirection permanente, c’est-à-dire que l’URL d’origine est redirigée.

0 : en général, ce terme désigne un élément d’URL qui provient d’un plug-in. Dans notre cas, on voit l’outil JCH qui génère une URL, car l’extension minimise les pages. Dans certains cas, les désindexations sont classées dans le même registre.

404 : Les erreurs de la sorte, proviennent de pages qui n’existent plus ou d’URL qui ont été modifiées. Pour éviter cela, il suffit d’apposer une redirection 301 ou 302 (provisoire). Cela permet aux moteurs de recherches de mieux comprendre les contenus et d’éliminer (6 mois après) les urls disparus. N’hésitez pas à supprimer ces anciens contenus dans la « Search console » de Google.

Comprendre les indexations et désindexations

Il n’est pas toujours recommandé d’indexer toutes les pages de notre site. En effet, un contenu qui n’apporte pas de réponses pertinentes en matière sémantique ou qui ne porte pas l’objectif de se positionner peut-être exclut de l’indexation. C’est le cas des pages institutionnelles que l’on sépare des autres telles que les mentions légales, les CGV, ou même les pages de paiement.

État des titres et de HN

En outre, le crawling d’un site apporte des données sur l’état des HN. Dans cet exemple, on s’aperçoit que certaines URL ne possèdent pas d’URL. Normal, il s’agit de pages au statut, 301 en y incluant des images. Notons que les visuels PNG ou JPG doivent faire apparaitre les balises « alt » ainsi que les titres de chaque entité.

Dans ce cas, on s’aperçoit qu’il y a du travail à fournir à l’origine de nombreux changements de page. Ces circonstances incorporent aussi les différentes URL et liens internes. Cette situation se précise lors du contrôle des balises canoniques au sein de pages désindexées. Souvent, le logiciel seo du site positionne cette balise alors que le Cms le désindexe. Encore des points à détailler : cela dépend des outils employés.

Métadescription

En déplaçant le curseur va droite, le crawleur, va lister les métas descriptions pour juger de la pertinence des mots-clés, mais aussi de leur simple présence (à la suite d’un oubli).

Étape 2 : Visualiser la sémantique à partir de cocon.se

Pendant, le crawl avec screaming frog, on peut lancer une étude sémantique à partir de cocon.se. Cet outil permet de comprendre l’importance des pages en fonction de leur « puissance » en matière de liens et de sémantiques. Chaque point désigne un article. L’ensemble de ces articles est relié à une page de plus haut niveau. En fonction de vos objectifs de position, vous pouvez décider du type de page qui sera optimisé.

Dans notre exemple, le cocon se montre assez basique. Les pages de catégories prennent plus de poids que les pages à référencer. Après une amélioration des pages de catégories, et une meilleure définition des liens, des titres et des mots-clés, on obtient un autre schéma plus pertinent.

En outre, certains cercles proviennent de pages institutionnelles qui n’apportent pas d’intérêt particulier pour le seo. Une fois éliminer (désindexation, et nouveaux types de liens), on peut réduire ces champs pour concentrer la force des liens vers les contenus qui nous intéressent.

Concrètement, la visualisation de l’architecture de votre site se construit en fonction des mots-clés et de la pertinence sémantique. Un gros travail de liens internes va aider à pousser les pages à ranker.

Test de duplication de contenu : il existe toujours des pages qui engendre ce problème soit à cause d’une redirection, soit par erreur.

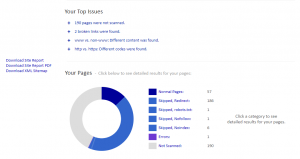

Étape 3 : éliminer les freins à votre référencement

Pour vérifier si les moteurs de recherche ne se confrontent pas à des difficultés d’exploration, un étalonnage peut éliminer bien des contraintes. En effet, par erreur, le robots.txt peut exclure des pages importantes sans même s’en apercevoir. Une vérification régulière amène à faire un point sur ce domaine en appliquant certaines conditions. Oui, il est recommandé, d’éliminer de l’exploration des contenus, mais attention à ne pas trop en faire. En listant trop d’éléments sur le fichier ROBOT.TXT, vous mettez à jour votre stratégie seo aux concurrents, sans parler des problèmes de sécurité.

Dans cette étape, le responsable marketing dresse une liste des pages pertinente et indexable puisqu’il dispose des informations nécessaires à partir du crawl.

Étape 4 études des mots-clés et opportunités

À ce stade, il appartient aux équipes seo de corroborer les contenus aux objectifs de référencement naturel.

- Il y a -t-il des opportunités manquées et comment agir rapidement ?

- Les pages stratégiques sont-elles correctement optimisées pour apporter satisfaction ?

- Faut-il créer de nouveaux contenus ou privilégier l’existant pour se positionner sur de nouvelles occurrences ?

- Les titres conviennent-ils aux intentions de recherche désirées ?

- Comment les métadescriptions impactent-elles le CTR, et agissent-elles en ma faveur ?

- Comment mes concurrents font-ils pour mieux se positionner que moi et qu’apportent-ils de concret ?

- Subissons-nous du « duplicate content » et comment réagir en conséquence ?

Étape 5 : autopsie de la popularité du site

Dans un dernier, temps, il tient lieu de populariser le site et de comprendre les types de liens entrants. Le netlinking favorise à ce titre les positions à condition qu’au préalable les contenus soient de qualité, ainsi que la structure du site est cohérente. Parfois, certains liens provenant de noms de domaines douteux peuvent être désavoués, mais cela fait toujours débat sur son efficacité. En matière de liens, le meilleur levier se concentre sur la dilution. C’est-à-dire que l’ajoute de liens de qualité va toujours améliorer l’ensemble de la popularité. C’est d’ailleurs l’une des astuces lorsque l’on subit une commande manuelle.

En conséquence, préparer une stratégie de netlinking avec une analyse à partir de Majestic par exemple pour ajouter de nouveaux liens.

Reporting et élaboration de la liste des propositions

Désormais, vous disposez de suffisamment d’informations en ce qui concerne votre projet. Ces points de contrôle vous aideront à déterminer un plan d’action. Pour commencer, il semble important de cadrer un temps.

Par exemple sur un mois, il est tout à fait possible de définir une stratégie pour vérifier les résultats. En dressant une action particulière chaque semaine avec une décomposition du projet chaque jour, vous pour visualiser l’évolution.

Évidement un projet déjà mûr va plus rapidement donner ses fruits qu’un site qui vivote depuis plusieurs mois sans véritablement de contenus. Néanmoins, en adoptant ce comportement, vous allez rapidement obtenir des résultats. Pour préparer votre projet, un article énumère les points afin d’élaborer un cahier des charges. Ensuite, le reporting de l’audit seo va être déposé sur un PowerPoint de présentation, mais on peut aussi le détailler sur Trello, ou mindmeister.